KI hier, KI da. Google hat neue Geräte mit KI-Funktionen herausgebracht und Apple verteilt bald seine ersten Betriebssysteme mit „Apple Intelligence“. Zudem sind ChatGPT, DALL-E, Gemini, Llama, MidJourney und Stable Diffusion weitflächig im Einsatz. Doch genau darin liegt auch das Problem für die Weiterentwicklung der zugrundeliegenden Modelle, etwa der Large Language Models (LLMs) von Chatbots. Denn werden diese mit zu viel KI-generierten Inhalten trainiert, kann es zum sogenannten „Model Collapse“ kommen. Zumindest ist das die Aussage einer Untersuchung der University of Oxford, die im Fachmagazin Nature veröffentlicht wurde.

Kapitel in diesem Beitrag:

KI-Ausfall: Was ist der sogenannte „Model Collapse“?

Chatbots wie ChatGPT werden mit Millionen von Texten und Milliarden von Wörtern trainiert, um Zusammenhänge erkennen und relevante Antworten auf Fragen geben zu können. Ähnlich sieht es bei KIs aus, die Bilder erzeugen und dafür mit einer Unzahl an Fotos, Kunstwerken, Skizzen und dergleichen gefüttert werden. Jedoch zeigt die oben verlinkte Untersuchung auf, dass KI-Modelle immer schlechtere Ergebnisse liefern, je mehr ihre Generationen mit den Ausgaben ihrer Vorgängergenerationen trainiert wurden.

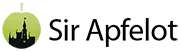

Als Beispiel wird ein Chat über historische Architektur gezeigt, der nach nur wenigen KI-trainierten Generationen des Chatbots zu unverständlichen Antworten mit der Nennung verschiedener Hasenarten führte. Ähnlich sieht es bei KI-Modellen aus, die Bilder erzeugen. Bereits in 2023 zeigte eine andere Untersuchung, dass bildgebende KI-Modelle bereits nach dem Training mit kleinsten Mengen eigener Bilder teilweise stark verzerrte Ergebnisse liefern. Der KI-Modell-Kollaps beschreibt also die Ausgabe von unverständlichen oder unkenntlichen Ergebnissen trotz Eingabe verständlicher Fragen oder Aufgaben.

Wie kommt es zum KI-Modell-Kollaps?

In der aktuellen Untersuchung im Nature-Magazin werden die Gründe für die unverständlichen und verzerrten Ausgaben der KIs aufgezeigt. Demnach werden wahrscheinliche Antworten und Satzelemente mit jeder Generation höher priorisiert, während unwahrscheinlichere Inhalte, Phrasen und Worte immer weiter zurückfallen und letztendlich vergessen werden. Die Antwort enthält nach mehreren Generationen von mit Vorgänger-Antworten trainierten KI-Modellen also komplett falsche Annahmen, Wortwiederholungen und dergleichen. Oder kurz: die KI „vergiftet“ ihre eigene Realität.

Stecken im ursprünglichen Trainingsmaterial für die Generation 0 dabei schon einige Fehler, die vielleicht sogar wiederholt werden und damit als wichtig erscheinen, dann werden diese in den Generationen n immer mehr verstärkt. Wenn die KI-Generationen mit Daten der Generation n-1 trainiert werden, wird als Antwortmöglichkeit irgendwann nur noch der Fehler angenommen. Kommt es dann auch noch zum grammatikalischen Kollaps, entstehen Wiederholungen wie im Chat-Beispiel der Untersuchung, wo es dann nur noch „[…] In addition to being home to some of the world’s largest populations of black @-@ tailed jackrabbits, white @-@ tailed jackrabbits, blue @-@ tailed jackrabbits, red @-@ tailed jackrabbits, […]“ heißt.

Worin liegt die Gefahr beim aktuellen KI-Training?

Sowohl für Chatbots als auch für Bilder oder Videos erzeugende KI-Modelle geht langsam das Trainingsmaterial zuneige. Das (frei verfügbare) Web ist für die größten Unternehmen und ihre Modelle schon so gut wie leer gefischt. Egal ob OpenAI, Google, Meta oder andere – der endlose Hunger nach zusätzlichen Texten und Datensätzen kann nur auf zwei Wegen gestillt werden: jedes bisschen brandneuen Inhalts direkt als Trainingsmaterial nutzen, und „synthetische Daten“ verwenden.

Da aber immer mehr KI-Inhalte das Web fluten, werden KI-Modelle eher früher als später mit ihren eigenen Ausgaben gefüttert. Und bei „synthetischen Daten“ handelt es sich um KI-erzeugte Datensätze, die speziell für das Training neuer Modelle erstellt werden. Neben der Gefahr einer versehentlichen „Vergiftung“ (Übertragung des Begriffs „Poisoning“ aus der Studie) wird KI also schon absichtlich mit den Inhalten von Vorgängermodellen trainiert – etwa bei Google und Meta. Weil echtes Material langsam zur Neige geht und zudem qualitativ hochwertige Quellen (Zeitungen, etc.) Geld für ihre Texte sehen wollen.

Gibt es eine Lösung für das Problem des KI-Modell-Kollapses?

Aktuell ist das in der Untersuchung gezeigte Ausmaß der Ausgabenverzerrung noch rein theoretisch. Denn bisher ist das Web noch nicht in der Menge von KI-Inhalten gefüllt, dass menschengemachte Inhalte in der verschwindenden Unterzahl sind. KI wird also nicht vornehmlich oder ausschließlich auf Basis von KI-Inhalten trainiert. Dennoch muss hier vorgesorgt werden, bestenfalls mit der Kooperation von KI-Firmen mit den Quellen für hochwertige, menschengemachte Datensätze. OpenAI arbeitet z. B. schon mit dem Springer-Verlag und News Corp. zusammen. Das kostet allerdings einige Millionen Dollar.

Eine weitere Lösung, die von den Untersuchenden der Oxford University angestoßen wird, ist eine gemeinschaftliche Absprache zwischen den KI-Firmen für die Klärung von Herkunftsfragen hinsichtlich der vorhandenen Datensätze. Es sollte also geprüft werden, ob Quellen möglicherweise aus dieser oder jener KI stammen, sodass sie entsprechend markiert und ggf. aus dem Datensatz für das Training entfernt werden können. Aber dies würde eine Automatisierung und somit eine weitere (Prüf-)KI voraussetzen. Denn manuell geprüft kann der Datenhunger des KI-Trainings nicht gestillt werden.

Ähnliche Beiträge

Johannes hat nach dem Abitur eine Ausbildung zum Wirtschaftsassistenten in der Fachrichtung Fremdsprachen absolviert. Danach hat er sich aber für das Recherchieren und Schreiben entschieden, woraus seine Selbstständigkeit hervorging. Seit mehreren Jahren arbeitet er nun u. a. für Sir Apfelot. Seine Artikel beinhalten Produktvorstellungen, News, Anleitungen, Videospiele, Konsolen und einiges mehr. Apple Keynotes verfolgt er live per Stream.