OpenAI will sich weiterhin als Platzhirsch auf dem Markt der generativen KI-Modelle behaupten. Neben dem Chatbot ChatGPT und der Bilderstellung DALL-E wurde deshalb nun ein Werkzeug zur Erzeugung von Videomaterial vorgestellt: Sora. Die Sora genannte KI von OpenAI erstellt hochauflösende und detailreiche Videos aus einfachen Textbefehlen, Bildern oder anderen Videos. Personen, Gebäude, Tiere, Pflanzen, bestimmte Szenen, Stile, Kamera-Arten, Epochen und dergleichen können dabei umgesetzt werden. Die bisherigen Ergebnisse aus der Entwicklung von OpenAI Sora sind beeindruckend, haben aber noch ausreichend Makel, um als KI-Material enttarnt zu werden. Noch…

Kapitel in diesem Beitrag:

- 1 OpenAI Sora erstellt bis zu 1 Minute inhaltlich konstante Videos

- 2 Sora steht noch am Anfang und ist nur begrenzt zugänglich

- 3 OpenAI macht auf die Schwächen der Video-KI aufmerksam

- 4 Mehr oder weniger nützliche Sicherheitsmechanismen angekündigt

- 5 Die Technik dahinter: Sora ist ein „Diffusion“-Modell

- 6 Sora kann Videos verlängern und Ausbessern sowie Bilder animieren

- 7 OpenAI und die AGI – Sora soll ein Schritt zur „Alles-KI“ sein

- 8 Ähnliche Beiträge

- 9 Sir Apfelot Wochenschau KW 16, 2025

- 10 Was bringt iOS 19 aufs Apple iPhone? (Gerüchteküche)

- 11 Apple-Updates: x.4.1-Versionen sollen Bugs und Sicherheitslücken beheben

- 12 10 Jahre Aktivitätsringe: 24. April 2025 als Aktionstag für Watch-User

- 13 Qi2-Ladegerät mit Lüfter: Perfekt für den Sommer oder kompletter Quatsch?

- 14 Sir Apfelot Wochenschau KW 15, 2025

- 15 Soundcore AeroClip: Open-Ear-Kopfhörer mit offenem Ring-Design

- 16 Mit MagSafe und Qi2: Pitaka Powerbank fürs iPhone ausprobiert

OpenAI Sora erstellt bis zu 1 Minute inhaltlich konstante Videos

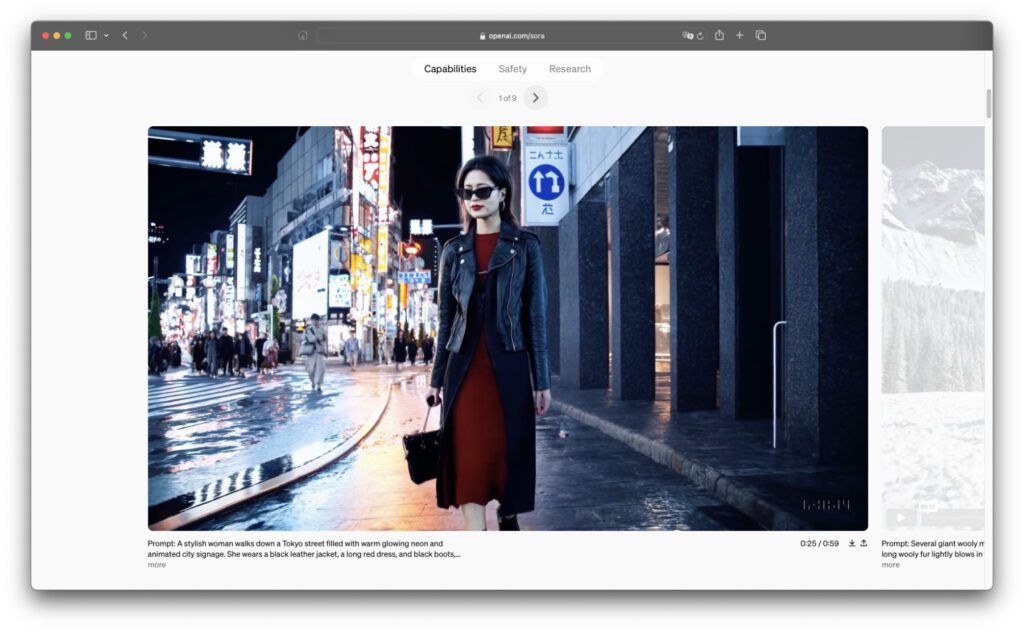

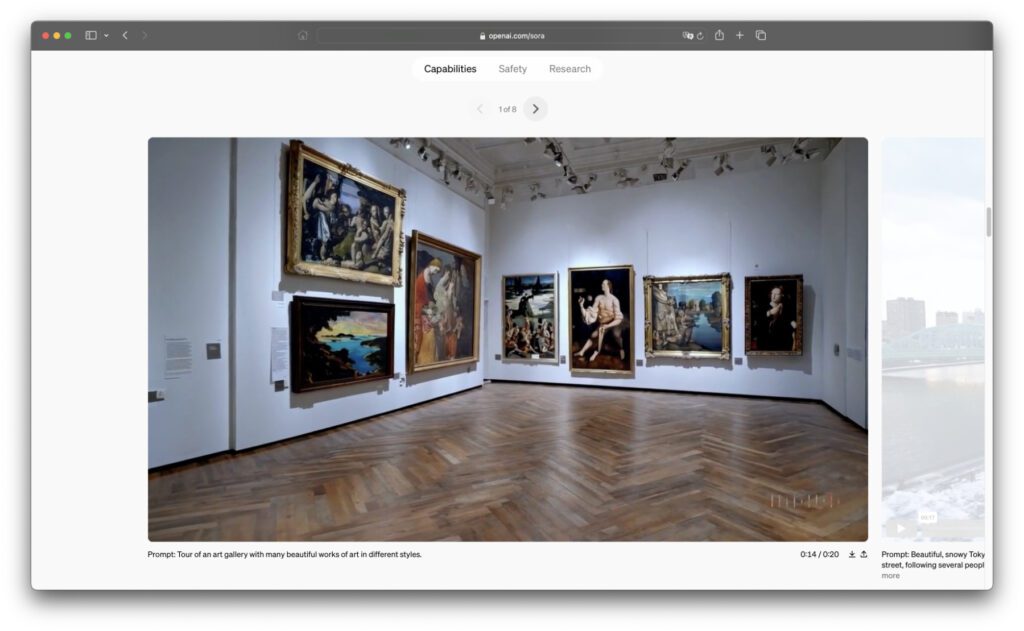

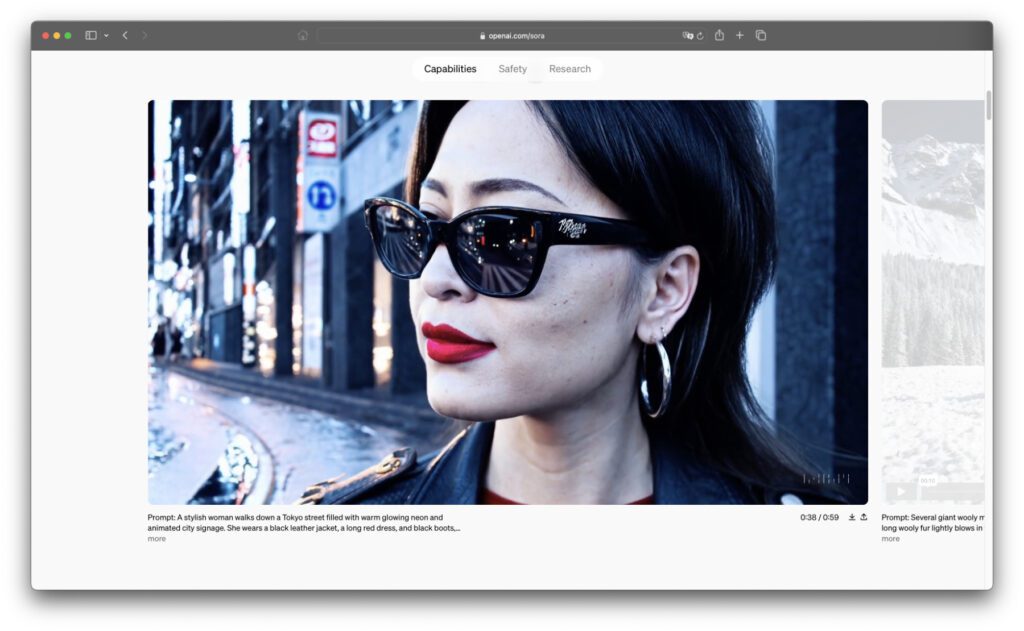

Von zwei Piratenschiffen, die in einer Tasse Kaffee kämpfen, über einen jungen Mann, der auf einer Wolke sitzend ein Buch liest, hin zu einer Parade zur Feier des Chinesischen Neujahrs ist alles und viel mehr möglich. Auf dieser Seite zeigt OpenAI, welche realistischen und fantastischen Szenen bereits mit der Sora-KI für Text-zu-Video-Aufgaben realisierbar sind.

Dabei geht es nicht nur um einzelne Fokusinhalte oder Protagonist/innen, die detailreich gerendert werden. Das gesamte Video inkl. Hintergründen und Nebencharakteren wird meist räumlich korrekt, mit komplexen Lichteffekten, physikalisch sinnvoller Ausstattung und dergleichen berechnet. Auf den ersten flüchtigen Blick wirkt das meiste Material echt.

Sora steht noch am Anfang und ist nur begrenzt zugänglich

Aktuell steht die Sora-KI nur dem „Red Team“ von OpenAI sowie professionellen Kreativen aus den Bereichen Film und Design zur Verfügung. Das sogenannte Red Team besteht dabei aus Leuten, die neue OpenAI-Technologien bezüglich ihrer Gefahren und Risiken testen. Gerade Video-KIs stecken ja voll davon, da mit ihnen theoretisch umfangreiche Deepfakes von Promis, Politiker/innen und auch Privatpersonen angefertigt werden können.

Während das Red Team also solche potenziellen Gefahren ausmachen soll, werden die professionellen User aus dem Kreativbereich einbezogen, um Feedback für die Verbesserung von Sora einzuholen. Es soll geschaut werden, welche Features für Kino, YouTube und Co. sinnvoll wären. Ein öffentlicher Zugang ist sicherlich geplant, dann hoffentlich aber mit Sicherheitsmechanismen gegen Missbrauch des Tools.

OpenAI macht auf die Schwächen der Video-KI aufmerksam

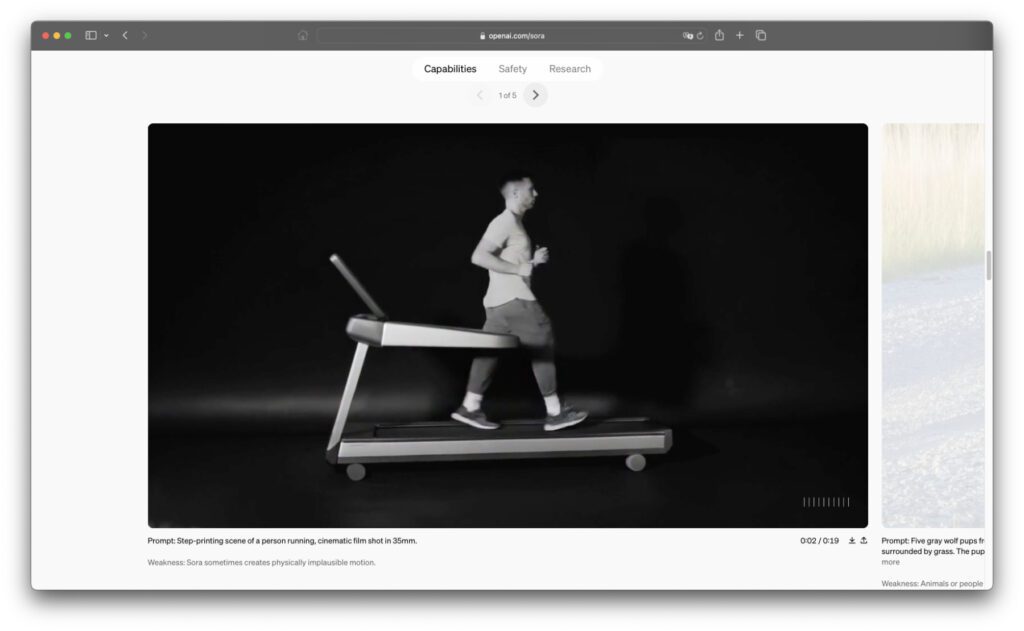

Neben wirklich eindrucksvollen und teils sehr realistisch wirkenden KI-Videos zeigt OpenAI auf der oben verlinkten Seite auch ein paar Ausreißer aus den bisherigen Versuchsläufen. So sollte Sora zum Beispiel eine Person auf einem Laufband animieren. Das hat zwar in der Theorie geklappt, nur läuft der Mann in die falsche Richtung.

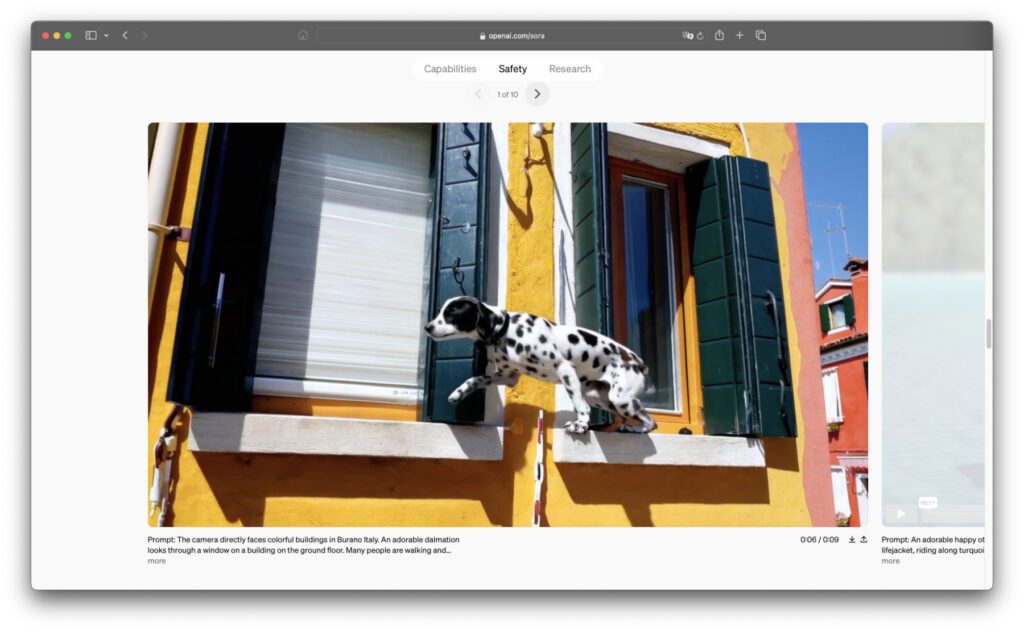

Ein anderes Beispiel zeigt Wolfswelpen, die auf einem Feldweg tollen. Das Problem: es erscheinen aus dem Bündel immer mehr der Tierchen, scheinbar aus dem Nichts. Auch in weiteren Beispielen erscheinen Objekte scheinbar aus dem Nirgendwo bzw. hinter anderen Objekten, die sie nicht wirklich hätten verdecken können. Auch Hände sind immer noch ein Problem, inklusive natürlicher Handbewegungen.

Mehr oder weniger nützliche Sicherheitsmechanismen angekündigt

Eine Video-KI, die (nahezu) realistische Szenen von bis zu 1 Minute Länge produzieren kann, bietet Chancen, aber natürlich auch Gefahren. OpenAI hat deshalb verschiedene Sicherheitsmechanismen angekündigt, die dem Missbrauch des Tools vorbeugen sollen. So sollen etwa Prompt-Filter implementiert werden, die verhindern sollen, dass bestimmte Eingaben in Videoform umgesetzt werden.

Speziell sollen extreme Gewalt, sexuelle Inhalte, hassvolle Darstellungen, Promi-Ähnlichkeiten oder die Nutzung von Franchise-Material (Charaktere aus Cartoons, Filmen, Serien, Videospielen, etc.) unterbunden werden. In die ausgegebenen Videodateien sollen wie bei Bildern von DALL-E zudem C2PA-Metadaten eingearbeitet werden. Aber diese lassen sich zugegebenermaßen leicht entfernen. Es bleibt abzuwarten, wie sicher die erste öffentliche Sora-Version sein wird.

Die Technik dahinter: Sora ist ein „Diffusion“-Modell

Wie auch bei entsprechenden Bild-KIs können Video-KIs als Diffusion-Modelle arbeiten. Das heißt, dass sie als ersten Schritt ein statisches Rauschen erzeugen und dann in zahlreichen Schritten das Rauschen so entfernen, dass letztendlich das beschriebene Bild bzw. Video entsteht. Anders als bei Bildern muss bei Videos zusätzlich eine Kohärenz erarbeitet werden, da Inhalte sich nicht plötzlich komplett verändern oder unrealistisch verformen sollten.

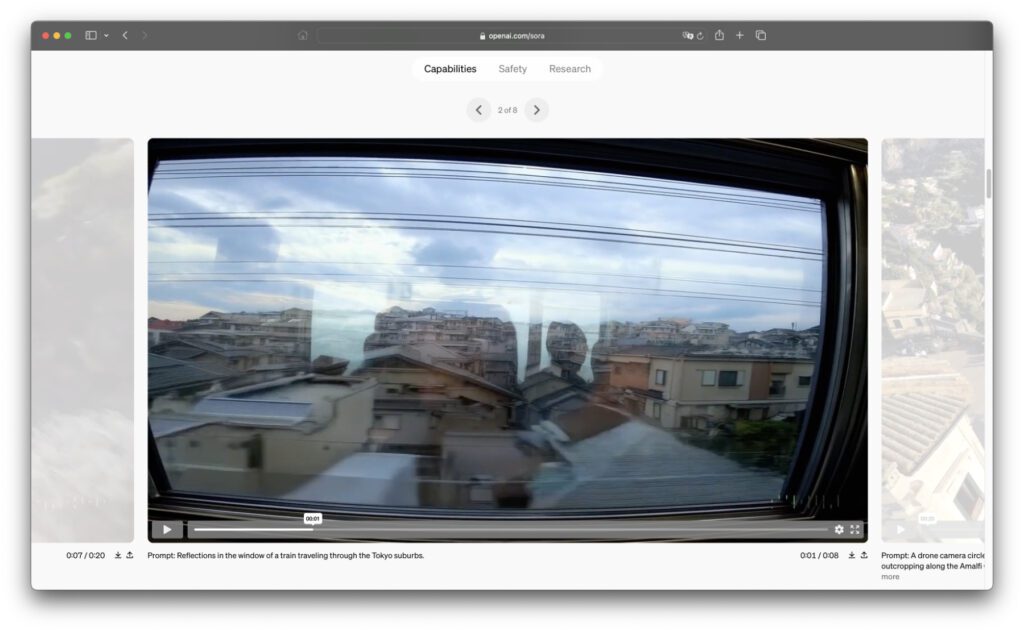

Außerdem müssen aus dem Blickfeld der virtuellen Kamera geratene Objekte und Charaktere bei Wiedereintritt in das Geschehen gleich aussehen. Auch dafür wurden im Sora-Modell Techniken implementiert. Letztendlich kann Sora aber auch als multimodales KI-Modell angesehen werden, denn es kann neben Texteingaben weiterhin Bilder und Videos als Ausgangsmaterial nutzen.

Sora kann Videos verlängern und Ausbessern sowie Bilder animieren

Neben Textbefehlen zum Kreieren von komplett neuen Videoinhalten kündigt OpenAI die Sora-KI zudem als Werkzeug zum Erweitern und Reparieren von vorhandenen Videos an. Weiterhin soll es mit der Video-KI möglich sein, eine Bilddatei auszuwählen und sie bei Beibehaltung der gezeigten Details und Werte zu animieren. Dabei kommt natürlich wieder Text zum Einsatz, um zu beschreiben, was in der animierten Version des Bildes passieren soll.

Auch bei der Verlängerung von Videos oder dem Einsetzen von neuen Inhalten bzw. dem Entfernen von unerwünschten Inhalten aus Videodateien kann man als User per Texteingabe kommunizieren, was letztendlich zu sehen sein soll. So kann ein Videoclip am Anfang und / oder Ende erweitert werden, um einen besseren Einstieg oder ein spannenderes Ende zu bieten. Personen könnten zudem entfernt oder hinzugefügt werden.

OpenAI und die AGI – Sora soll ein Schritt zur „Alles-KI“ sein

Ein großer Teil der Sora-Ankündigung besteht aus der Beschreibung der kreativen Möglichkeiten, die sich durch die multimodale Video-KI ergeben. Dennoch schließt der lange Beitrag mit den vielen Video-Beispielen, Beschreibungen der zugrunde liegenden Technik und anderen Details mit diesem Satz (frei übersetzt): „Sora dient als Grundlage für Modelle, welche die reale Welt verstehen und simulieren können – eine Fähigkeit, von der wir glauben, dass sie ein wichtiger Meilenstein auf dem Weg zur AGI sein wird.“

Bei der AGI handelt es sich um die „Artificial General Intelligence“, welche in der Theorie jede intellektuelle Aufgabe verstehen und lösen können soll. Dieses noch theoretische Konstrukt wäre ein hochautonomes System, dessen genaue Form noch nicht einheitlich definiert ist. Die AGI ist wie jede KI mit Chancen und Risiken verbunden. Mehr Details zum Thema sowie Links zu passender Fachliteratur gibt es bei Wikipedia.

Ähnliche Beiträge

Johannes hat nach dem Abitur eine Ausbildung zum Wirtschaftsassistenten in der Fachrichtung Fremdsprachen absolviert. Danach hat er sich aber für das Recherchieren und Schreiben entschieden, woraus seine Selbstständigkeit hervorging. Seit mehreren Jahren arbeitet er nun u. a. für Sir Apfelot. Seine Artikel beinhalten Produktvorstellungen, News, Anleitungen, Videospiele, Konsolen und einiges mehr. Apple Keynotes verfolgt er live per Stream.