Seit einigen Jahren nutzen Hersteller von VR-Headsets den Begriff „Foveated Rendering“, um die Fortschrittlichkeit ihrer Geräte hervorzuheben. Die Forschung zu dieser Art der Bild- und Szenenerzeugung mit unterschiedlichen Schärfe- bzw. Detailgraden im Sichtfeld der Nutzer/innen dauert dabei schon über 30 Jahre an. Aber erst in den letzten Jahren scheint die Technik leistungsstark genug geworden zu sein, um Foveated Rendering zu ermöglichen – auf dem HTC Vive Pro Eye, auf der Oculus Quest / Meta Quest, auf dem Sony PlayStation VR 2 (PSVR2) sowie am Apple Vision Pro, das am 5. Juni 2023 vorgestellt wurde. Doch was ist Foveated Rendering eigentlich?

Kapitel in diesem Beitrag:

- 1 Der Begriff: Was ist Foveated Rendering?

- 2 Woher kommt der Name „Foveated Rendering“?

- 3 Die Technik: Wie funktioniert Foveated Rendering?

- 4 Ohne Eye Tracking: Static / Fixed Foveated Rendering

- 5 Mit Eye Tracking: Dynamic Foveated Rendering

- 6 Video: Foveated Rendering Demo in nur 45 Sekunden

- 7 Die Herausforderung: Reaktion auf Augenbewegungen unter 13 Millisekunden

- 8 Wie die Technik im Apple Vision Pro Headset eingebunden wird

- 9 Zusammenfassung: Foveated Rendering in Virtual Reality Headsets

- 10 Quellen für die eigene Recherche

- 11 Ähnliche Beiträge

- 12 Qi2-Ladegerät mit Lüfter: Perfekt für den Sommer oder kompletter Quatsch?

- 13 Soundcore AeroClip: Open-Ear-Kopfhörer mit offenem Ring-Design

- 14 Mit MagSafe und Qi2: Pitaka Powerbank fürs iPhone ausprobiert

- 15 Was ist eine „virtuelle Softwarekarte“ auf der Nintendo Switch?

- 16 iVANKY Fusion Dock Pro 3 – 11-in-1 Thunderbolt 5 Dock günstiger kaufen

- 17 Mac-Hilfe: Bluetooth deaktiviert und Maus / Trackpad lässt sich nicht mehr nutzen

- 18 Manus – KI-Agent für komplexe Aufgaben (+ Open-Source-Alternative)

- 19 Europäischer Suchindex: Ecosia und Qwant arbeiten an Google-Alternative

Der Begriff: Was ist Foveated Rendering?

Foveated Rendering beschreibt die Bildsynthese für VR- und AR-Anwendungen an entsprechenden Headsets unter Einbeziehung der Blickrichtung, sodass im Fokus befindliche Bildinhalte schärfer bzw. detaillierter sowie nur peripher betrachtete Inhalte weniger scharf / weniger detailliert dargestellt werden. Oder einfacher ausgedrückt: Nutzt man ein Virtual Reality Headset mit Foveated Rendering, dann werden nur die angesehenen Teile der Displayinhalte in der höchsten Auflösung dargestellt. Was nicht direkt angesehen wird, das wird auch nicht in voller Auflösung und mit den detailliertesten Texturen gerendert.

Der Vorteil ist, dass in direkter Blicklinie die höchste Bildqualität genutzt werden kann, während die Bildränder weniger Rechenleistung in Anspruch nehmen. Jedoch stellt das die technische Forschung, die herstellenden Firmen, die Entwickler/innen der genutzten Software und Spiele sowie nicht zuletzt die Geräte in der schließlichen Nutzung vor mehrere Herausforderungen. Denn Augenbewegungen sind schnell, die Reaktionszeit des Gehirns ist ebenfalls rasant und das VR-Headset ist nur so gut wie die Technik, die darin verbaut ist.

Woher kommt der Name „Foveated Rendering“?

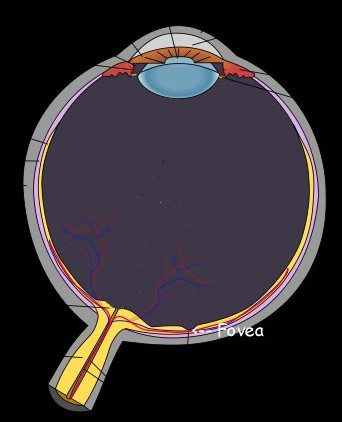

Der erste Teil des Begriffs, nämlich „Foveated“, bezieht sich auf die Fovea centralis im menschlichen Auge. Dieser lateinische Begriff bedeutet so viel wie „mittige Grube“ und beschreibt die sogenannte Sehgrube auf der Netzhaut des Auges. Es handelt sich dabei um den Bereich des schärfsten Sehens (foveales Sehen). Der Durchmesser der Fovea centralis misst rund 1,5 mm und es befinden sich dort etwa 147.000 Lichtrezeptoren (Zapfen) pro Quadratmillimeter, vor allem M- und L-Zapfen für den grünen und roten Bereich des sichtbaren Lichts, weniger S-Zapfen für blaues Licht.

Der zweite Teil des Begriffs, nämlich „Rendering“, bezieht sich auf die computergestützte Bilderzeugung aus Rohdaten. In Betriebssystemen, Software mit grafischer Oberfläche, Videospielen, Apps und dergleichen werden Daten, Befehle, Koordinationen und weitere Informationen genutzt, um eine Bildausgabe zu erzeugen, die dann den Nutzer/innen auf dem Ausgabegerät angezeigt wird. In der Erzeugung von einzelnen Bilddateien kommt es dabei auf die Schnelligkeit der Renderprozesse an. Bei Bewegtbild- und Multimedia-Inhalten werden diese in kurzer Zeit mehrfach wiederholt. Die fps-Zahl gibt dabei an, wie viele Bilder pro Sekunde errechnet und ausgegeben werden.

Als kompletter Begriff beschreibt „Foveated Rendering“ also das Erstellen von Computergrafiken bzw. virtuellen Szenen, die nur in direkter Blickrichtung vollständig und scharf berechnet werden. Alles, was außerhalb der geraden Linie zur Fovea centralis liegt, wird weniger scharf und / oder mit weniger aufwändigen Texturen ausgegeben. Der Renderprozess kann somit beschleunigt werden und verbraucht weniger Ressourcen, während die Nutzer/innen keine (merkliche) Verminderung der Bildqualität hinnehmen müssen. So können z. B. VR-Spiele im Blickfeld in 4K-Auflösung dargestellt werden, während an den Displayrändern eine geringere Auflösung zum Einsatz kommt. Also ein Zusammenspiel aus fovealem und peripherem Sehen.

Die Technik: Wie funktioniert Foveated Rendering?

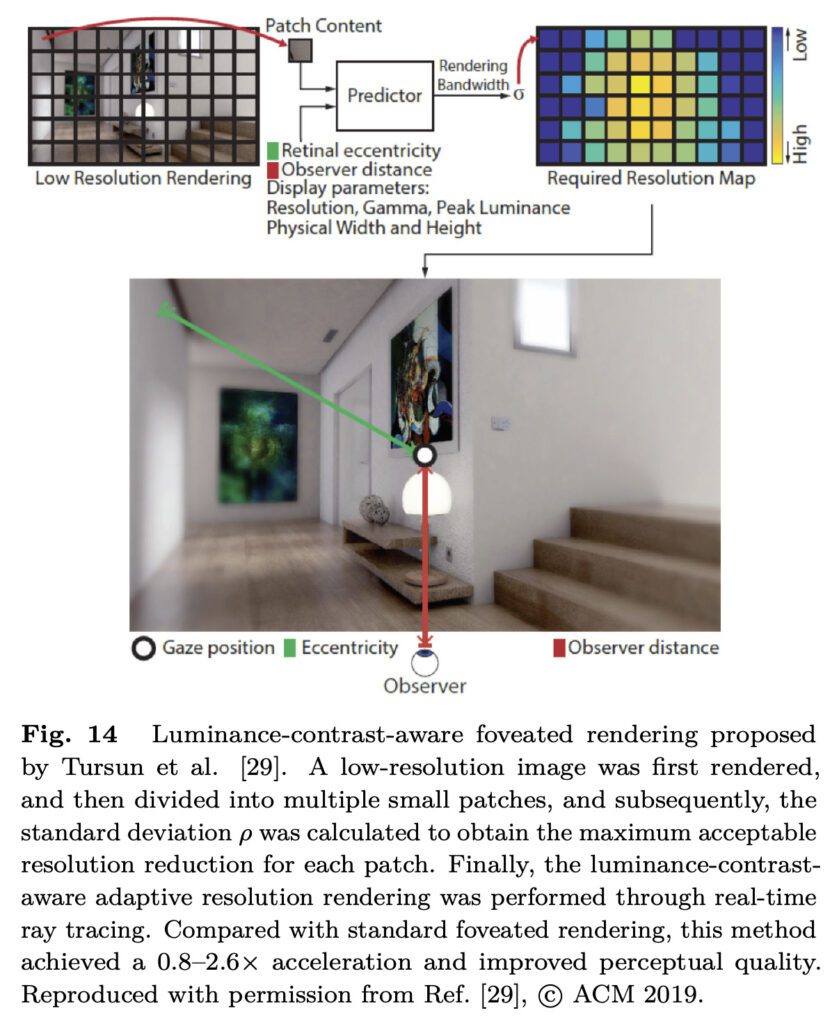

Für die Realisierung dieser Technik gibt es verschiedene Herangehensweisen, ausgehend von der Art des Foveated Rendering, das angeboten werden soll. Am bequemsten und natürlichsten für die Nutzer/innen ist das Dynamic Foveated Rendering, bei dem die Blickrichtung durch Augen-Tracking ermittelt und der scharfe Bildbereich entsprechend neu positioniert wird. Allerdings ist dies die technisch aufwändigste Umsetzung. Fixed oder Static Foveated Rendering setzt voraus, dass die Nutzer/innen nur geradeaus oder auf einen anderen Fixpunkt schauen, weshalb lediglich derselbe komplett scharf gerendert wird und die Schärfe bzw. der Detailgrad hin zu den Bildrändern abnimmt.

Ohne Eye Tracking: Static / Fixed Foveated Rendering

Der Vorteil im Fixed Foveated Rendering liegt darin, dass das Virtual Reality Headset bei der Berechnung einzelner Bilder nicht jedes Mal eine neue Augenposition und damit eine neue Blickrichtung als Datengrundlage einbeziehen muss. Das heißt, es gibt für die Eingabeauswertung weniger Rechenaufwand und die Prozessoren werden dafür weniger stark beansprucht. So kann (im Vergleich gesehen) anspruchslosere Technik verwendet und / oder der Stromverbrauch gesenkt werden. Weiterhin können sich die Hersteller die Technik für das Augen-Tracking sparen und das Gerät wird günstiger.

Der Nachteil liegt natürlich darin, dass das Virtual Reality Headset entweder nur die Bildmitte oder als interessant bewertete Bildinhalte in höchster Auflösung darstellt. In einem Videospiel könnte es also sein, dass lediglich der Spielcharakter und seine nähere Umgebung vollständig gerendert angezeigt werden, während Bereiche weiter weg von ihm unscharf erscheinen. Hier müssen sich die Entwickler/innen auf Spieletests und damit verbundene Messungen der Blickrichtung verlassen, es kann nicht ad hoc darauf reagiert werden, wo die Spielenden wirklich hinsehen.

Mit Eye Tracking: Dynamic Foveated Rendering

Der Vorteil des Dynamic Foveated Rendering / Dynamically Foveated Rendering liegt darin, dass bei der Bildberechnung im VR-Headset die Blickrichtung der Nutzenden mit einbezogen wird. Schaut man in der virtuellen Szene nach links, dann werden die linken Displayseiten scharf dargestellt, die Mitte weniger scharf und die rechten Displaybereiche am wenigsten aufgelöst. Schaut man nach rechts, dann werden die rechten Displayseiten höher aufgelöst, und so weiter. Diese Technik lässt eine natürlichere Nutzung zu und stellt Entwickler/innen nicht vor die Aufgabe, das Blick-Interesse bei der Anwendung vorhersehen zu müssen.

Der Nachteil besteht daraus, dass die VR-Brille bei jeder Bildberechnung auf die Blickrichtung der Nutzenden eingehen muss. Dies muss extrem schnell geschehen, da man sich in kurzer Zeit auf verschiedenste Objekte in den unterschiedlichsten Richtungen konzentrieren kann. Die Augenbewegungen, das schnelle Registrieren von Bildinhalten und das unvorhersehbare Umentscheiden bei der Auswahl von wichtigen Szeneninhalten stellen hier eine Herausforderung dar. Die Registrierung von Augenbewegung (Eye Tracking), das Berechnen des Sichtfelds und die entsprechende Bildsynthese müssen sich in einem kleinen Bruchteil einer Sekunde abspielen. Das bedarf modernster Technik und optimierter Prozesse.

Video: Foveated Rendering Demo in nur 45 Sekunden

In diesem Video wird gezeigt, wie Foveated Rendering in Kombination mit Deep Learning funktionieren kann. Dafür wurde das angesehene Objekt mit einer höheren Pixeldichte bedacht und aus dem Rest des Bildes 95% der Pixel entfernt. So wurde die etwaige Auflösung der Augennetzhaut simuliert. Die nun fehlenden Pixel wurden dann durch eine KI ersetzt, was mit wachsender Entfernung zum betrachteten Objekt zwar zu immer abstrakteren Formen führt, insgesamt aber keinen Unterschied macht, da die entfernten Inhalte nur peripher gesehen und somit nicht detailliert vom Gehirn wahrgenommen werden.

Die Herausforderung: Reaktion auf Augenbewegungen unter 13 Millisekunden

Aus einer Untersuchung von Mary C. Potter, Brad Wyble, Carl Erick Hagmann und Emily S. McCourt, deren Ergebnisse in 2013 veröffentlicht wurden, geht hervor, dass Menschen neue Bildinhalte – oder zumindest den Hauptinhalt der Bilder – binnen 13 ms erfassen können. Im Detail heißt es in der Studie „Detecting meaning in RSVP at 13 ms per picture“, die in Attention, Perception, & Psychophysics, Volume 76, Issue 2 im Februar 2014 veröffentlicht wurde:

The results of both experiments show that conceptual understanding can be achieved when a novel picture is presented as briefly as 13 ms and masked by other pictures. Even when participants were not given the target name until after they had viewed the entire sequence of six or 12 pictures, their performance was above chance even at 13 ms […]

Die Herausforderung für moderne Virtual Reality Headsets mit Dynamic Foveated Rendering besteht also darin, die Berechnung von detaillierten und unscharfen Bildbereichen in einem Takt von 0,013 Sekunden vorzunehmen. Kein Wunder also, dass die Entwicklung des Apple Vision Pro Headsets so lange gedauert hat und dass neben dem M2 Chip der neue R1 Chip verbaut wurde, der ausschließlich für die Interpretation von Sensor-Daten gemacht ist. In der Pressemitteilung zum Apple Vision Pro heißt es entsprechend:

[…] während der brandneue R1 Chip den Input aus zwölf Kameras, fünf Sensoren und sechs Mikrofonen verarbeitet und sicherstellt, dass sich die Inhalte anfühlen, als ob sie in Echtzeit vor den Augen der Nutzer:innen stattfänden. R1 überträgt den Displays innerhalb von 12 Millisekunden neue Bilder […]

Wie die Technik im Apple Vision Pro Headset eingebunden wird

Laut Apple ist Dynamically Foveated Rendering ein Teil des visionOS-Betriebssystems. Entwickler/innen können ihre Inhalte damit anpassen, indem sie die Apple-Werkzeuge Xcode und Reality Composer Pro nutzen. Für bestimmte Apps und Spiele kann zudem Unity nativ unter visionOS genutzt werden. Die Unity Spiele-Engine ergänzt dabei das visionOS SDK ( SDK = Software Development Kit), das RealityKit, das UIKit und die vorbenannten Apple-Angebote für Programmierung, AR-Gestaltung, VR-Anwendungen und dergleichen mehr.

Auf der Developer-Seite zum Thema (hier) heißt es dazu entsprechend:

Now, you can use Unity’s robust, familiar authoring tools to create new apps and games or reimagine your existing Unity-created projects for visionOS. Your apps get access to all the benefits of visionOS, like passthrough and Dynamically Foveated Rendering, in addition to familiar Unity features like AR Foundation. By combining Unity’s authoring and simulation capabilities with RealityKit-managed app rendering, content created with Unity looks and feels at home on visionOS.

Zusammenfassung: Foveated Rendering in Virtual Reality Headsets

Foveated Rendering beschreibt im Hinblick auf Bildinhalte der Virtuellen Realität (VR) sowie in einigen Fällen auch der Augmented Reality (AR) eine Konzentration von Rechenprozessen auf das Sichtfeld der Nutzer/innen, in dem foveales Sehen eine Rolle spielt. In Bereichen des peripheren Sehens, also für wortwörtlich nur am Rande wahrgenommene Inhalte können dabei Ressourcen gespart werden, da sie nicht so hoch aufgelöst und mit weniger großen Texturen dargestellt werden. Vor allem im dynamischen Foveated Rendering besteht die Herausforderung daraus, in kürzester Zeit (unter oder in 13 Millisekunden) auf Augenbewegungen zu reagieren und entsprechend angepasste Bildinhalte auszugeben.

Quellen für die eigene Recherche

Im Folgenden findet ihr eine Liste mit Quellen, die ich bei der Recherche für diesen Beitrag genutzt habe. Diese ergänzen die im Beitrag bereits verlinkten Inhalte, welche ebenfalls als Quellen angesehen werden können:

- Englischer Wikipedia-Artikel zum Thema: Hier ansehen

- Deutscher Wikipedia-Artikel zur Fovea centralis: Hier ansehen

- State-of-the-Art Studie zu Foveated Rendering aus dem Jahr 2022, von Lili Wang, Xuehuai Shi & Yi Liu (veröffentlicht Anfang 2023): Hier ansehen

Ähnliche Beiträge

Johannes hat nach dem Abitur eine Ausbildung zum Wirtschaftsassistenten in der Fachrichtung Fremdsprachen absolviert. Danach hat er sich aber für das Recherchieren und Schreiben entschieden, woraus seine Selbstständigkeit hervorging. Seit mehreren Jahren arbeitet er nun u. a. für Sir Apfelot. Seine Artikel beinhalten Produktvorstellungen, News, Anleitungen, Videospiele, Konsolen und einiges mehr. Apple Keynotes verfolgt er live per Stream.